GPT-4, une solution innovante dans la modération de contenu

Publié le 24 août 2023

Écouter une version audio de cet article

La modération de contenu est devenue un élément essentiel pour garantir la sécurité, la pertinence et la qualité des informations sur les plateformes en ligne. Avec l’augmentation exponentielle du contenu généré par les utilisateurs, la nécessité d’une modération efficace est plus importante que jamais. OpenAI a récemment introduit une nouvelle approche pour améliorer la modération de contenu en utilisant son modèle de pointe, GPT-4.

Le rôle crucial de la modération de contenu

La modération de contenu ne se limite pas à la suppression de contenus offensants ou inappropriés. Elle joue un rôle vital dans la création d’un environnement en ligne sûr et bienveillant pour tous les utilisateurs. Les plateformes numériques, qu’il s’agisse de réseaux sociaux, de forums ou de sites d’actualités, sont confrontées à une multitude de défis, tels que la désinformation, le harcèlement en ligne et la propagation de contenus haineux.

La modération traditionnelle, bien que nécessaire, repose fortement sur des modérateurs humains, ce qui peut être à la fois coûteux, lent et mentalement éprouvant pour les modérateurs.

L’innovation d’OpenAI : L’introduction de GPT-4

Avec GPT-4, OpenAI a introduit un modèle de traitement du langage naturel qui a le potentiel de transformer de nombreux domaines, y compris la modération de contenu. GPT-4 est capable d’interpréter les nuances et les subtilités du langage, ce qui le rend particulièrement adapté à la compréhension des politiques de contenu complexes et à l’adaptation rapide aux mises à jour.

Contrairement aux approches traditionnelles, GPT-4 peut traiter d’énormes quantités de données en un temps record, offrant ainsi une solution plus rapide et plus efficace.

Le fonctionnement de GPT-4 dans la modération

Grand modèle de langage (LLM) : OpenAI utilise des LLMs, comme GPT-4, qui sont capables de comprendre et de générer du langage naturel. Ces modèles peuvent prendre des décisions de modération basées sur des directives politiques.

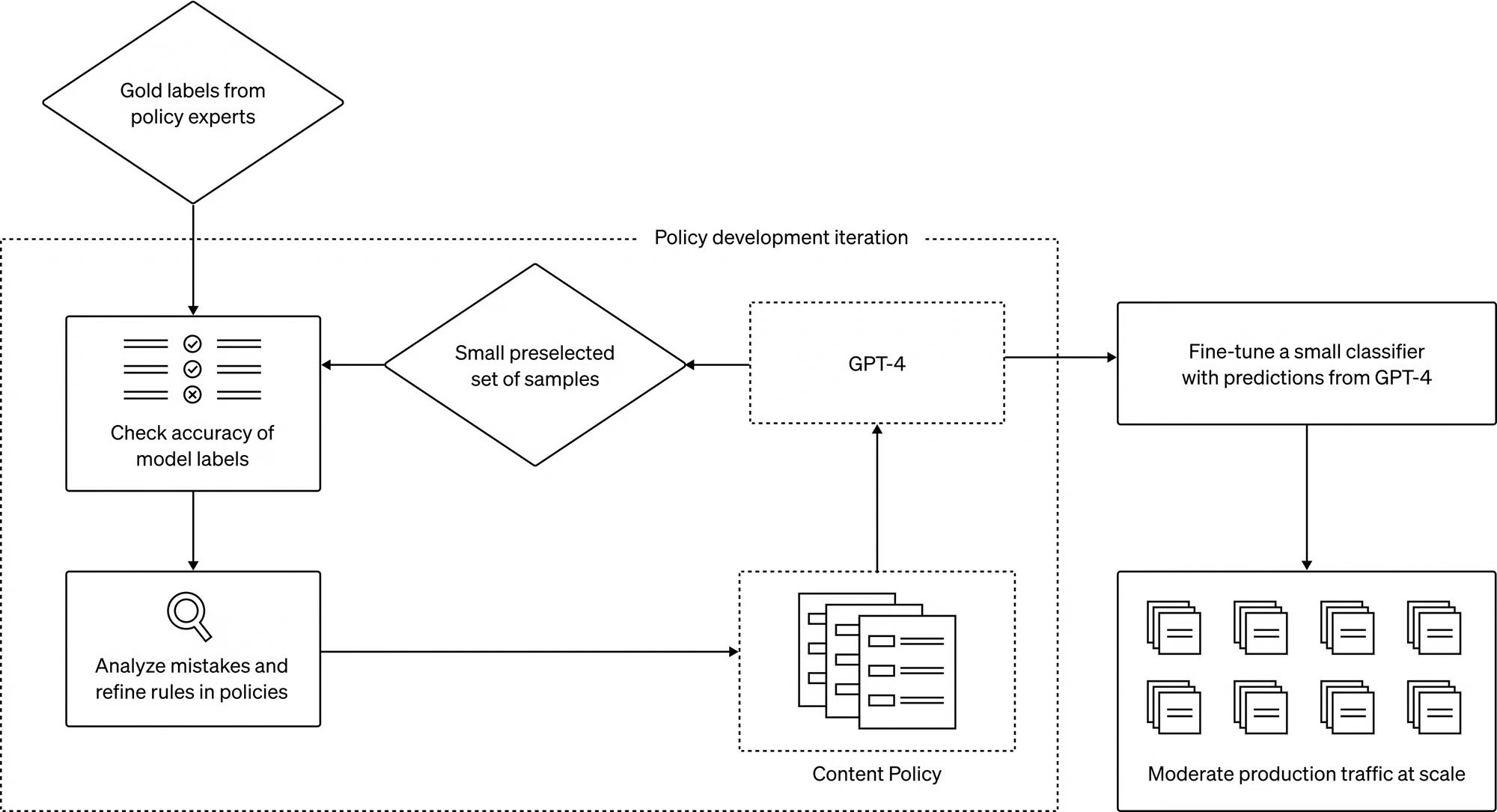

Processus itératif : Une fois une directive politique rédigée, les experts peuvent créer un ensemble de données « gold » en identifiant quelques exemples et en leur attribuant des étiquettes. GPT-4 lit ensuite la politique et attribue des étiquettes au même ensemble de données, sans voir les réponses. Les experts en politique peuvent alors comparer les jugements de GPT-4 à ceux des humains, affiner les définitions de politique et répéter le processus jusqu’à ce qu’ils soient satisfaits de la qualité de la politique.

Déploiement à grande échelle : Ce processus itératif permet de traduire les politiques de contenu en classificateurs, ce qui permet de déployer la politique et la modération de contenu à grande échelle. Pour gérer de grandes quantités de données, les prédictions de GPT-4 peuvent être utilisées pour affiner un modèle plus petit.

Avantages et implications de l’utilisation de GPT-4

Étiquetage cohérent : GPT-4 offre une expérience de contenu cohérente, évitant les incohérences qui peuvent survenir avec des modérateurs humains.

Boucle de retour d’information rapide : La capacité de GPT-4 à réduire le processus de mise à jour des politiques à quelques heures permet de répondre rapidement aux nouveaux défis.

Réduction du fardeau mental : En automatisant une partie significative de la modération, le fardeau mental des modérateurs humains est allégé.

Limitations et défis à venir

L’adoption de GPT-4 par OpenAI pour la modération de contenu, bien que prometteuse, n’est pas sans ses défis. Comme tout outil basé sur l’intelligence artificielle, GPT-4 présente des limitations inhérentes à sa conception et à sa formation.

Biais dans les données : L’un des principaux défis de l’utilisation des modèles d’IA est le risque de biais. Ces biais peuvent provenir des données sur lesquelles le modèle a été formé. Si les données d’entraînement contiennent des préjugés ou des stéréotypes, le modèle risque de les reproduire dans ses décisions. Cela peut entraîner des jugements inéquitables ou discriminatoires, ce qui est particulièrement préoccupant dans le contexte de la modération de contenu.

Interprétabilité : La nature « boîte noire » des modèles de deep learning, comme GPT-4, pose des défis en matière d’interprétabilité. Comprendre pourquoi un modèle a pris une décision particulière peut être complexe, ce qui rend difficile la correction des erreurs ou des biais.

Dépendance technologique : Bien que l’automatisation puisse améliorer l’efficacité, une dépendance excessive à la technologie peut entraîner une négligence des nuances humaines. Il est crucial de maintenir un équilibre entre l’automatisation et l’intervention humaine pour garantir une modération de contenu équilibrée.

Adaptabilité aux nouvelles menaces : Les menaces en ligne évoluent constamment. Les acteurs malveillants peuvent trouver des moyens de tromper ou de contourner les systèmes automatisés. GPT-4 devra être constamment mis à jour et formé pour répondre à ces nouvelles menaces.

Questions éthiques : L’utilisation de l’IA pour la modération de contenu soulève également des questions éthiques. Qui est responsable en cas d’erreur ? Comment garantir la transparence et la responsabilité dans les décisions automatisées ? Ces questions nécessitent une réflexion approfondie et une réglementation appropriée.

Envie d’en savoir plus ou d’être accompagné sur ce type de problématiques digitales, n’hésitez pas à nous contacter !