GPT-5 : un lancement sous le feu des critiques (justifiées)

Publié le 11 août 2025

Écouter une version audio de cet article

Le nouveau modèle GPT-5 d’OpenAI, très attendu, a suscité autant d’enthousiasme que d’inquiétudes lors de son lancement il y a quelques jours. Sam Altman, le PDG d’OpenAI, avait alimenté la fébrilité ambiante avec des comparaisons audacieuses : GPT-5 serait au précédent modèle ce que l’écran Retina fut aux vieux smartphones pixélisés. Mais une fois le modèle disponible, l’euphorie s’est vite changée en cacophonie de réactions contrastées. Entre annonces triomphantes d’OpenAI et désillusions des utilisateurs, le lancement de GPT-5 a été mouvementé. Explications !

Promesses techniques : puissance et « expert PhD » au menu

OpenAI a présenté GPT-5 comme son modèle de langage le plus abouti, un bond en avant sur plusieurs plans. Plus rapide et plus précis, il est censé commettre moins d’erreurs que ses prédécesseurs et réduire drastiquement les hallucinations, ces réponses inventées que ChatGPT fournissait parfois en l’absence de bonnes données. « GPT-5, c’est la première fois qu’on a l’impression de parler à un expert niveau PhD », a clamé Sam Altman, situant les progrès en une phrase : « GPT-3, c’était un lycéen ; GPT-4, un étudiant ; GPT-5, un docteur ». La comparaison se veut éloquente et plante le décor d’un assistant virtuel nettement plus compétent en raisonnement complexe et en programmation. Altman n’a pas hésité à déclarer qu’il s’agit du « meilleur modèle au monde en codage, en rédaction, en santé… », rien de moins.

Concrètement, GPT-5 unifie les capacités autrefois séparées en un seul modèle polyvalent. Fini l’interface déroutante où l’utilisateur devait choisir entre un mode rapide ou “réfléchi” : un routeur intelligent se charge désormais de basculer automatiquement en mode raisonnement approfondi pour les requêtes complexes ou sur demande explicite de l’utilisateur. OpenAI a même ajouté des personnalités configurables à ChatGPT, avec quatre thèmes (Cynique, Robot, Attentif, Passionné) permettant d’ajuster le ton des réponses. L’objectif affiché : rendre l’IA plus adaptable et agréable pour le grand public, tout en intégrant des capacités accrues. Lors d’une démonstration, l’équipe a ainsi montré GPT-5 générant en quelques secondes le code complet d’un site web éducatif interactif, soit 600 lignes de programmation produites quasi instantanément. Ces prouesses alimentent la vision d’une ère de « software on demand » où l’on pourrait créer des applications par simple instruction en langage naturel.

OpenAI affirme avoir soumis GPT-5 à plus de 5 000 heures de tests de sécurité afin d’en cerner les risques et d’améliorer sa fiabilité. Le modèle aurait appris à mieux reconnaître ses limites : il prévient plus souvent quand une tâche dépasse ses connaissances ou n’est pas réalisable, plutôt que de répondre n’importe quoi. Alex Beutel, responsable de la recherche sécurité, souligne qu’une emphase particulière a été mise sur l’honnêteté des réponses pour réduire les mensonges convaincus du modèle. En parallèle, GPT-5 excelle aux benchmarks internes : il pulvérise les scores de codage sur des tests de programmation (SWE-Bench, etc.), surclassant tous les modèles maison précédents. Sur le papier, tous les indicateurs sont au vert. Pourtant, derrière ces améliorations tangibles, de premières voix discordantes se sont fait entendre dès les premières heures.

Formation « ChatGPT »

Optimisez votre temps de production et augmentez l’efficacité de votre équipe grâce à notre formation sur l’utilisation de ChatGPT pour la création de contenus éditoriaux, le référencement, la traduction, les réseaux sociaux et bien plus encore, tout en abordant les questions éthiques importantes liées à cette technologie.

Colère des utilisateurs : une mise à jour perçue comme un recul

Il n’a pas fallu longtemps pour que la fête tourne au vinaigre. Moins de 24 heures après la mise en ligne, une fronde d’utilisateurs fidèles de ChatGPT a éclaté, furieuse de la manière dont la transition a été imposée. OpenAI a en effet déployé GPT-5 en remplaçant brutalement tous les modèles précédents dans l’interface (y compris le très apprécié GPT-4o) sans laisser l’option de revenir en arrière. Du jour au lendemain, les abonnés payants de ChatGPT Plus ont vu disparaître leurs outils de prédilection, forcés d’adopter GPT-5 comme unique choix. La réaction ne s’est pas fait attendre : « C’est une trahison ! », « On nous impose une régression ! » pouvait-on lire sur les forums et Reddit, où un fil intitulé « GPT-5 is horrible » a recueilli des milliers de votes d’approbation en quelques heures

Surtout, nombre d’utilisateurs ont dénoncé une baisse de qualité flagrante. Sur Reddit comme sur X, les témoignages se multiplient : GPT-5 fournirait des réponses « plus courtes, moins pertinentes » et perdrait en logique. Certains comparent le nouveau chatbot à un « zombie beige et corporatiste », tant son ton leur paraît édulcoré et formaté. Cette impression de régression fonctionnelle, avec des réponses moins étoffées et parfois à côté de la plaque, donne à beaucoup le sentiment d’avoir été rétrogradés. « On a l’impression d’un déclassement plutôt que d’un progrès », résume un abonné dépité. Plus inquiétant, certains signalent même une augmentation des hallucinations (l’exact contraire de la promesse initiale) comme si la bête traînait de nouveaux angles morts.

Les clients payants de ChatGPT Plus, parmi les plus investis, ont aussi découvert avec stupeur de nouvelles limites bridant leur usage. Le mode dit “GPT-5 Thinking”, censé approfondir les réponses, est plafonné à 200 messages par semaine : un quota facilement atteignable pour les utilisateurs réguliers. De plus, la variété de modèles alternatifs (comme o4-mini et consorts) a été purement et simplement supprimée au profit du tout-en-un GPT-5. Et même s’il y avait un réel besoin de clarifier l’offre (objectivement on s’y perdait), là c’est un peu exagéré !

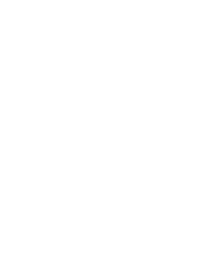

Côté API, GPT-5 monte officiellement à 400 000 tokens de contexte total, avec jusqu’à 128 000 tokens en sortie (le budget de « raisonnement » est compté dedans). En pratique, cela permet d’ingérer un gros dépôt de code ou un long rapport en une seule passe. À noter : plusieurs docs et analyses précisent un plafond d’entrée autour de ~256–272k tokens selon les modes, le reste étant alloué à la sortie. Dans ChatGPT, la fenêtre effective varie selon l’offre et le déploiement : OpenAI ne promet pas 400k dans l’UI, et des retours d’utilisateurs Plus signalent un cap à 32k au lancement (sujet en cours d’ajustement). Bref : 400k en API pour les cas lourds, mais des limites plus basses côté produit grand public pour l’instant.

Couacs en série et mea culpa du PDG

OpenAI ne s’attendait visiblement pas à une telle volée de bois vert, et quelques erreurs de lancement ont aggravé les choses. Lors de la présentation en direct, l’équipe d’Altman a commis ce que la communauté a vite nommé le « chart crime » : un graphique comparatif affiché à l’écran montrait une barre de performance de GPT-5 exagérément haute par rapport à GPT-4o, alors que l’écart réel n’était pas si énorme. La bourde était flagrante (une barre de 74,9% dessinée bien plus haute qu’une barre de 69,1% voisine), au point de faire ricaner jusqu’aux plus fervents supporters d’OpenAI. Pris la main dans le sac de cette présentation trompeuse, Sam Altman a dû présenter des excuses publiques pour ce « méga ratage » de communication.

Plus grave, certains problèmes techniques ont entamé l’expérience utilisateur dès le premier jour. De nombreux testeurs se plaignaient que GPT-5 semblait moins intelligent que prévu, ratant des questions que GPT-4o réussissait. Lors d’une session AMA sur Reddit organisée en urgence, Sam Altman a reconnu un bug du nouveau routeur : le système de sélection automatique de mode (rapide vs réfléchi) ne fonctionnait pas correctement au lancement, ce qui bridait les performances du modèle. « GPT-5 avait l’air plus bête, mais c’était à cause d’une panne du routage automatique », a-t-il expliqué, annonçant qu’un correctif était déployé en moins de 24h pour que GPT-5 « paraisse plus intelligent dès aujourd’hui ». Altman a promis davantage de transparence sur le fonctionnement de ce routeur : prochainement, l’interface indiquera quel sous-modèle (rapide ou “pensant”) répond à chaque requête, pour dissiper la confusion.

Face à la grogne, OpenAI a dû faire marche arrière sur plusieurs points. Sur Reddit, le PDG a été assailli de demandes pour rétablir GPT-4o, auquel beaucoup restent attachés. D’abord réticent, Altman a fini par céder du terrain : « Nous envisageons de permettre aux utilisateurs Plus de continuer à utiliser 4o. Nous récoltons plus de données sur les compromis », a-t-il concédé publiquement. Quelques jours à peine après l’avoir mis au placard, OpenAI annonçait le retour de GPT-4o comme option pour les abonnés payants, en guise de filet de sécurité. De même, Altman a promis de doubler les limites d’utilisation de GPT-5 pour les clients Plus durant la période de transition, afin de calmer le jeu. « Le lancement a été un peu cahoteux », a admis la firme dans un rare moment d’humilité, s’engageant à « stabiliser la situation tout en écoutant les retours ». Autant de mesures d’urgence qui sonnent comme un aveu : OpenAI a sous-estimé l’attachement de sa communauté aux anciens modèles et la tolérance zéro de celle-ci pour les régressions.

Un modèle révolutionnaire… ou simple évolution incrémentale ?

Au-delà des problèmes de lancement, une critique de fond émerge : GPT-5 est-il réellement la avancée majeure annoncée ? Si ses améliorations en codage et en capacité de traitement sont notables, beaucoup d’experts tempèrent l’enthousiasme d’OpenAI. « GPT-5 brille dans des tâches techniques comme la programmation, mais des erreurs embarrassantes montrent qu’on est dans l’évolution incrémentale plus que dans la révolution », résume un observateur de l’industrie. En clair, le modèle reste faillible et imprévisible à ses heures, loin d’une intelligence artificielle pleinement fiable ou compréhensive, et encore plus loin de l’IA générale tant attendue (et fantasmée).

OpenAI, de son côté, campe sur une communication mesurée quant à la portée de GPT-5. Sam Altman admet lui-même que ce modèle n’est « pas (encore) doté de quelque chose d’important ». Il fait ici allusion à la capacité d’apprentissage continu en cours d’usage, un trait qui serait nécessaire selon lui pour parler d’AGI (intelligence générale) et dont GPT-5 est dépourvu. « Ce n’est pas un modèle qui apprend en continu de nouvelles informations une fois déployé, et pour moi cela devrait faire partie d’une vraie AGI », a-t-il concédé. Une façon de reconnaître que, malgré ses avancées, GPT-5 reste une intelligence artificielle spécialisée, figée dans son entraînement initial. D’ailleurs, certains indicateurs suggèrent qu’OpenAI a dû faire des compromis : la taille du contexte de GPT-5, annoncée à 128k tokens, semble en pratique limitée pour des raisons de coût, ce qui fait grincer des dents certains développeurs observateurs. L’entreprise vise une base d’un milliard d’utilisateurs, ce qui implique d’optimiser les ressources (GPU, coûts serveurs), peut-être au prix d’une pleine performance du modèle pour chaque utilisateur. Ces arbitrages alimentent le soupçon que GPT-5, plus qu’une prouesse scientifique, est aussi un produit calibré pour l’échelle et la rentabilité. Et concrètement, GPT-5, ne vaut pas mieux que Claude Opus 4 !

Entre espoirs et désillusions, quel bilan pour GPT-5 ?

GPT-5 restera comme l’un des lancements les plus mouvementés de l’histoire d’OpenAI. D’un côté, le modèle confirme la trajectoire ascendante des capacités de l’IA générative : il code mieux, raisonne plus finement et introduit des fonctions inédites qui élargissent le champ d’application de ChatGPT. Offert gratuitement (du moins en accès de base) à des centaines de millions d’utilisateurs, il témoigne de l’ambition d’OpenAI de garder une longueur d’avance technologique et de populariser l’IA à grande échelle. De l’autre, la réception houleuse révèle un fossé grandissant entre les promesses marketing et l’expérience vécue par les usagers et experts. L’arrogance perçue d’OpenAI (balayer les anciens modèles du jour au lendemain en pensant que le nouveau les surpasserait en tout) a coûté cher en capital confiance. L’entreprise a dû rétropédaler en urgence pour réparer ce que certains qualifient de faux pas stratégique.

Surtout, GPT-5 illustre que les défis de fond demeurent. Malgré un enrobage plus poli, il reste une « machine à conneries » potentielle, pour reprendre les mots d’utilisateurs dépités, susceptible de produire des erreurs avec aplomb. Sa sortie tant attendue et les réactions qui l’ont accompagnées ont braqué les projecteurs sur la nécessité d’aller au-delà du simple accroissement de puissance brute. Faut-il ralentir la course en avant pour consolider les acquis ? D’éminents spécialistes estiment qu’atteindre une intelligence artificielle vraiment fiable exigera d’explorer de nouvelles approches (IA hybridant symbolique et réseau de neurones, meilleures architectures, etc.) plutôt que de seulement gaver des modèles toujours plus grands de données. En ce sens, GPT-5 pourrait marquer un tournant : celui où la communauté prend conscience qu’une étape qualitative reste à franchir.

Entre temps, OpenAI devra tirer les leçons de ce lancement chahuté. L’entreprise a montré qu’elle savait écouter (réintégrer GPT-4o, corriger les bugs, ajuster les limites) mais elle joue gros sur la confiance à long terme. Sam Altman a comparé le développement de l’IA aux débuts du nucléaire, évoquant même le “moment Trinity” de l’essai atomique pour décrire ce qu’il a ressenti en testant GPT-5. Une analogie lourde de sens, oscillant entre fierté et crainte, qui prend un relief particulier après la réception tiède de cette “bombe” technologique. Car si GPT-5 n’a pas déclenché l’enthousiasme unanime escompté, il a au moins le mérite de rappeler que chaque saut en avant de l’IA s’accompagne d’un examen critique salutaire. OpenAI espérait un triomphe, elle aura finalement reçu une leçon d’humilité, et la communauté, elle, aura gagné une occasion de débattre de la voie à suivre pour l’intelligence artificielle de demain.

La question elle est vite répondue

Qu’est-ce que GPT-5 apporte réellement par rapport à GPT-4o ?

GPT-5 améliore nettement le raisonnement outillé : il enchaîne des appels d’outils en série ou en parallèle avec plus de fiabilité et gère mieux les erreurs. Côté création logicielle, OpenAI revendique un gap en génération front-end et en debug de dépôts volumineux, avec une meilleure “sensibilité” design. Dans ChatGPT, le choix de modèle est simplifié par un routeur temps réel qui bascule automatiquement vers un mode plus “réfléchi” pour les requêtes difficiles. Ces promesses restent des déclarations éditeur : elles demandent toujours une vérification par cas d’usage et données internes à chaque équipe. En résumé, les gains existent, mais ils valent d’être mesurés sur votre stack et vos workflows, pas seulement sur scène.

Pourquoi OpenAI a-t-il retiré les anciens modèles au lancement… et est-ce revenu en arrière ?

Le déploiement initial a remplacé les modèles visibles dans l’UI, ce qui a déclenché une forte grogne d’utilisateurs habitués à GPT-4o pour leurs tâches quotidiennes. Suite au backlash, Sam Altman a reconnu un lancement “cahoteux” et a annoncé le retour de GPT-4o pour les abonnés Plus. Des fils Reddit détaillent la marche à suivre pour le réactiver dans les réglages. Message à retenir : OpenAI peut encore bouger les lignes du catalogue en production, y compris sur des modèles plébiscités. Si vous dépendez d’un comportement précis, verrouillez vos environnements API et vos versions.

Fenêtre contextuelle : quelle différence entre l’API et ChatGPT ?

Officiellement, la famille GPT-5 en API annonce 400 000 tokens de contexte et jusqu’à 128 000 tokens en sortie, selon la documentation et les pages modèles. En revanche, dans l’interface ChatGPT, plusieurs retours signalent une limite effective bien plus basse pour les comptes Plus au lancement, typiquement 32k, avec des ajustements en cours. Ce décalage n’est pas inédit : l’API expose le plafond “théorique”, l’UI impose des caps produits et de capacité. Pour les gros documents et chaînes d’outils longues, privilégiez l’API et vérifiez la tokenisation réelle dans vos tests. Pour l’UI, partez du principe que la marge sera inférieure et évolutive

Que s’est-il passé avec le “chart crime” pendant la démo, et qu’est-ce que ça dit des benchmarks ?

Lors du live de présentation, un graphique comparatif a été mal tracé, exagérant visuellement l’écart entre GPT-5 et GPT-4o. Altman a admis un “méga ratage” et OpenAI a corrigé la communication après coup. Ça ne suffit pas à invalider tous les tests, mais ça rappelle une règle simple : ne jamais sur-interpréter un slide marketing. Appuyez-vous sur vos propres mesures, des évaluations indépendantes et des jeux de tests pertinents pour votre métier. Les benchmarks publics sont un indicateur, pas une vérité universelle.

GPT-5 hallucine-t-il encore ?

OpenAI affirme une baisse des hallucinations et une meilleure “honnêteté” du modèle. Dans la pratique, des témoignages d’utilisateurs ont parlé de réponses plus courtes, parfois moins pertinentes, surtout dans les premières 48 heures. Une partie du problème provenait d’un bug du routeur qui a brouillé la perception de la qualité au lancement, corrigé ensuite selon la direction. Moralité : les hallucinations ne disparaissent pas par magie ; elles se gèrent par design de prompts, outillage (recherche, RAG), garde-fous et revues humaines. Évaluez la fiabilité sur vos tâches “à enjeu” avant de généraliser.

Le routeur automatique a-t-il pénalisé les performances au démarrage ?

Oui, OpenAI a reconnu un souci dans le routage entre modes qui a fait paraître GPT-5 “plus bête” que prévu pour certains. L’entreprise dit avoir déployé un correctif rapidement et promet plus de transparence pour afficher quel sous-mode répond. Au-delà du bug ponctuel, c’est un point d’attention durable : tout routage adaptatif peut introduire des effets de bord non désirés selon vos prompts. Si votre usage est sensible, préférez l’API et forcez les paramètres critiques plutôt que de laisser l’UI décider. Surveillez les mises à jour produit, le comportement peut encore évoluer.

Combien coûte réellement GPT-5 et comment anticiper la facture ?

Les pages officielles affichent des tarifs par million de tokens, distincts en entrée et en sortie, avec des variantes mini et nano pour optimiser coût/latence. La clé budgétaire, ce n’est pas seulement le prix facial, c’est la longueur de contexte, la verbosité des sorties et l’enchaînement d’outils. Sur des charges agentiques, GPT-5 appelle plus souvent des fonctions mais s’embrouille moins, ce qui peut réduire les itérations, ou les augmenter si votre orchestration est mal conçue. Testez avec de “vrais” scénarios, mesurez le coût par tâche réussie, pas le coût par appel. Et segmentez vos cas : use-cases critiques sur GPT-5, tâches routinières sur mini/nano.

Puis-je rester sur GPT-4o ou choisir un autre modèle si GPT-5 ne me convient pas ?

Oui, pour les abonnés Plus, GPT-4o a été rétabli comme option après le tollé. La bascule se fait dans les paramètres de ChatGPT, avec un toggle pour afficher les “modèles hérités”. C’est une bonne pratique de garder un plan B dans votre boîte à outils, surtout si un modèle nouveau casse un flux critique. En API, la maîtrise des versions et des déploiements reste la meilleure assurance qualité. Conservez vos prompts et évaluations par modèle pour pouvoir basculer rapidement.

GPT-5 est-il “meilleur” que Claude, Gemini ou Mistral ?

La bonne réponse, c’est “ça dépend de la tâche”. OpenAI met en avant un état de l’art en codage et en tâches agentiques, mais les comparaisons inter-marques varient selon les datasets, le tool use et les contraintes de sécurité. Attendez des comparatifs indépendants récents, idéalement répliqués, et faites vos propres A/B sur des lots réels. Ne vous fiez pas à une démo isolée, positive ou négative. Le bon modèle est celui qui vous donne le meilleur coût par résultat fiable, dans votre environnement.

Comment se préparer côté compétences pour tirer parti de GPT-5 en entreprise ?

Les avancées de GPT-5 ne dispensent pas d’une montée en maturité : cadrage des cas d’usage, prompts robustes, RAG outillé, politique de revues et d’escalade. C’est exactement ce que couvre une formation “IA générative” sérieuse : transformer des promesses générales en processus maîtrisés, avec des métriques de qualité et des garde-fous. Si vous voulez accélérer côté équipes (marketing, RH, relation client, data), une montée en compétences guidée vous fera gagner des mois d’essais/erreurs. Vous pouvez vous appuyer sur mes formations IA générative pour structurer cette adoption de manière concrète et mesurable. Et surtout, capitalisez vos prompts et évaluations pour industrialiser les meilleures pratiques.

Et pour ChatGPT au quotidien : quelles bonnes pratiques avec GPT-5 ?

Même avec un modèle plus “intelligent”, la différence se fait dans la méthode : contexte propre, consignes explicites, contrôle de la verbosité, et tests systématiques. L’usage des outils (recherche, code, fonctions internes) doit être scénarisé, pas laissé au hasard. La gestion des tokens reste critique : découpez, résumez, indexez, ne collez pas “tout le PDF” sans stratégie. Si vos équipes veulent muscler ces réflexes rapidement, une formation dédiée “ChatGPT” accélère l’appropriation et réduit les erreurs coûteuses. L’objectif n’est pas d’écrire un “beau prompt”, mais d’obtenir des sorties fiables et exploitables, à coup sûr.

Grégory JEANDOT

Consultant sr et Formateur IA

Avec un langage simple (et non simpliste), Grégory décrypte l’univers de l’IA générative. Pas de sémantique complexe ou d’approche trop verbeuse : l’objectif est de faire monter tout le monde en compétence !

![[Étude] L’IA fait gagner 1 jour par semaine aux chefs de projet. Vraiment ?](https://tous-les-jeudis.fr/wp-content/uploads/2025/11/tous-les-jeudis-formation-ia-gestion-de-projet-gain-de-temps.jpeg)